智东西

智东西

智东西6月10日报说念,当天,苹果开荒者大会WWDC25坐实了大模子版Siri跳票的音讯,而备受期待的苹果AI也被吐槽“拖后腿”。

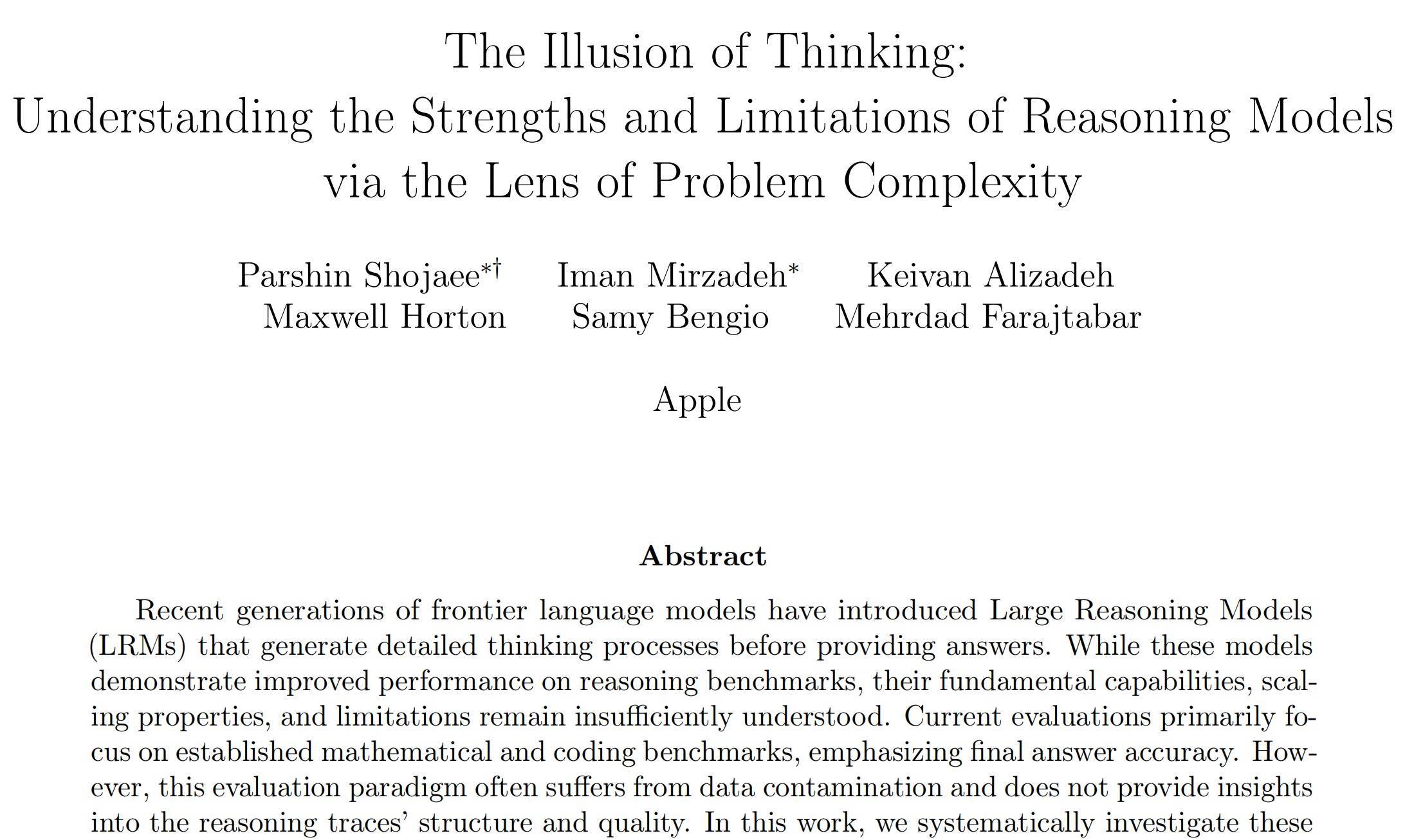

就在这两天,苹果发布的一篇对于大模子的新论文引起热议,该论文试图极力于论证大型推理模子(LRMs)的澈底性崩溃。

研发东说念主员设想实验测试了Claude 3.7 Sonnet、DeepSeek-R1、o3 mini等推理模子,得出论断:大型推理模子在处理简便问题时存在“过度念念考”问题;而当问题的复杂性飞腾到临界点时,它们修起问题的准确性就会触发“崩溃模式”,以致准确度低到接近零。

▲苹果发布论文《念念维的错觉:通插手题复杂性视角清楚推理模子的上风与局限性》

“这(论文)对大谈话模子来说是十分具有撤消性的。”好意思国东说念主工智能鸿沟盛名意见首领Gary Marcus说。

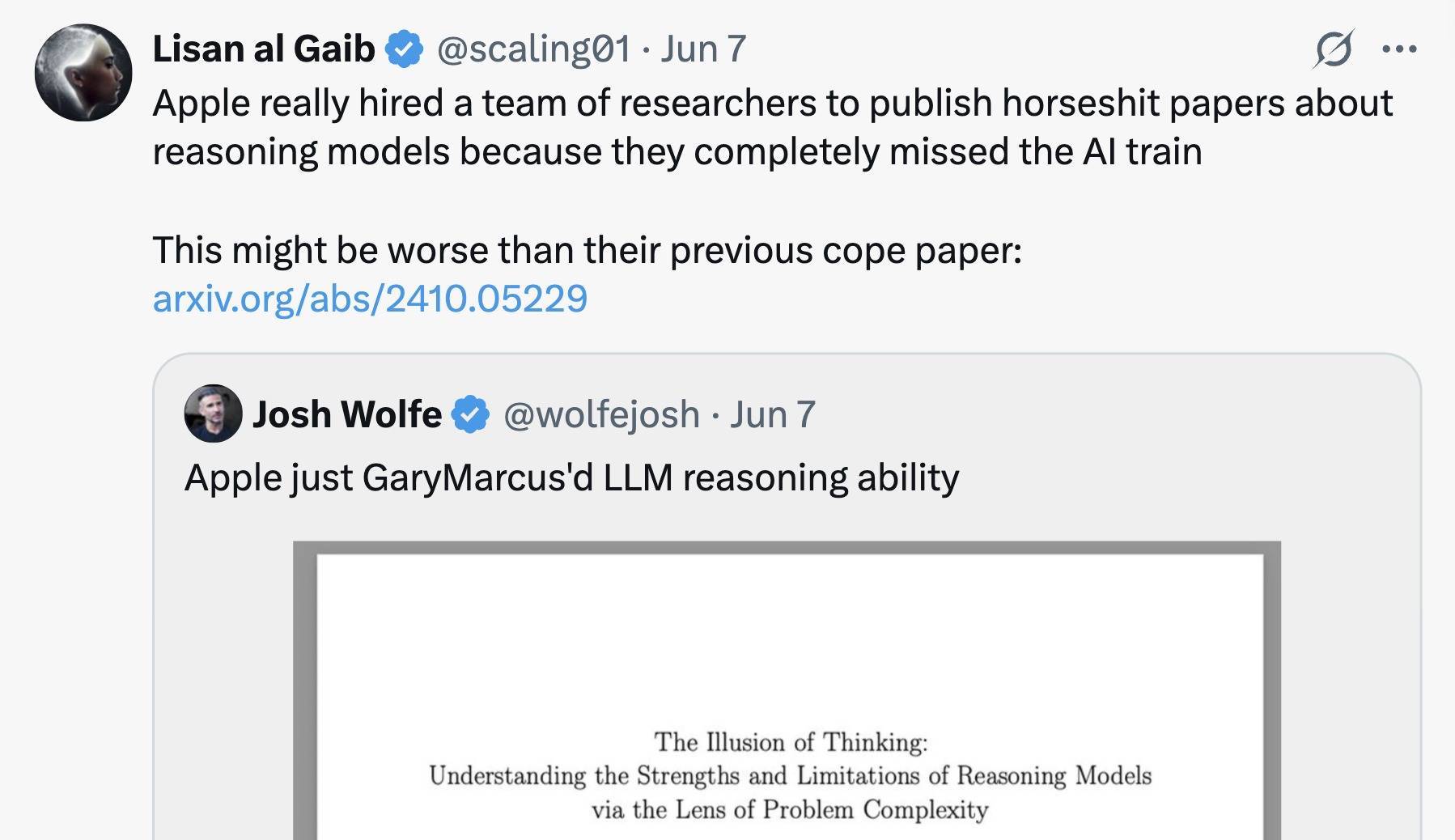

投资公司Bootstrapped创举东说念主Ruben Hassid将论文转发至酬酢平台X上称:“苹果刚刚诠释,像Claude、DeepSeek-R1和o3-mini这么的AI‘推理’模子本色上根柢不具备推理武艺。它们只是能很好地记取模式辛苦。”这条推文预览了超1000万,挑剔达到2600多条。盛名风投Lux Capital聚开创举东说念主兼结伙东说念主Josh Wolfe也推选共享了这篇论文。

但这篇论文同期也引起了深广质疑。苹果论文试图诠释,AI推理模子是假的,只是模式匹配机器。但不少用户提到:“咱们只可等着看论文来诠释东说念主类的推理不单是是驰念模式了。”用外网爆火的梗图来说等于,就算苹果诠释了模子无法作念推理和原始念念考,但东说念主类就能了吗?

一些东说念主以致称这篇论文是“烂文”,并拿“用锤子敲螺丝”来描写苹果团队实验的极端。有用户通过复现苹果团队的实验以诠释苹果的论证存在逻辑缝隙,比如游戏的野心次数不成代表复杂度,大模子崩溃只是因为输出太长等。

另外有网友扒出论文作家的配景,论文聚首一作如故别称实习生,是弗吉尼亚理工大学打算机科学专科三年龄博士生,这也成为质疑者的发难点。

还有不少用户觉得,苹果之是以辩白大模子程度是因为其我方错过了这波AI机遇。

论文地址:https://machinelearning.apple.com/research/illusion-of-thinking?utm_source=perplexity

起初来看实验设想,苹果团队的大多数实验在推理模子及对应非推理模子上进行,举例Claude 3.7 Sonnet(带/不带深度念念考)和DeepSeek-R1/V3。团队允许最大token预算为64k。

测试不是基于当下主流基准测试进行的,因为苹果觉得这些测试受数据沾污影响严重,并无法深远了解推理轨迹的结构和质地,因此其通过25个谜题实例进行了测试。

1、DeepSeek、Claude在高复杂度任务上十足崩溃

谜题环境允许在保抓一致逻辑结构的同期,精准适度组合复杂性。苹果觉得,这种建设不仅或者分析最终谜底,还能分析里面推理轨迹,从而深远了解大型推理模子的“深度念念考”方式。

对于每个谜题实例,团队生成25个样本,并答复每个模子在这些样本上的平均性能。团队通过调换问题限制N(示意圆盘数、棋子数、块数或过河元素数)来改变复杂性,从而扣问复杂性对推理举止的影响。

下图展示了两种模子类型在总计谜题环境中当作问题复杂性函数的准确性。

下图清楚了这些模子对在等效推理token打算下的上限性能武艺,也等于跨总计谜题的平均值,将早期从数学基准的分析延迟到可控的谜题环境。

这两个图的效果标明,与基准测试中的不雅察不同,这些模子的举止在复杂性不同的问题中存在三种情况:

(1)在低复杂度任务上,圭臬模子的推崇出东说念主料到地优于大型推理模子;

(2)在中等复杂度任务上,大型推理模子的额外深度念念考推崇出上风;

(3)在高复杂度任务上,两种模子的推崇皆十足崩溃。

2、接近复杂度临界值,推理模子运行“偷懒”

接下来,苹果团队扣问了配备推理token的不同成心推理模子若何应酬不断加多的问题复杂性。其实验评估了五种起初进的推理模子:o3-mini(中等和高配置)、DeepSeek-R1、DeepSeek-R1-Qwen-32B和Claude-3.7 Sonnet(深度念念考版)。

下图展示了这些模子在不同复杂性级别上的准确性(顶部)和推理token使用情况(底部)。效果标明,总计推理模子在复杂性方面皆推崇出不异的模式:跟着问题复杂性的加多,准确性逐步着落,直到进取特定于模子的复杂性阈值后十足崩溃,准确度为零。

团队还不雅察到,推理模子领先跟着问题复杂性的加多按比例加多其推理token。关系词,在接近一个与它们的准确性崩溃点密切对应的临界阈值时,模子违背直观地运行减少推理极力。

这种气候在o3-mini变体中最为昭着,在Claude-3.7-Sonnet(深度念念考版)模子中则不那么严重。值得瞩宗旨是,尽管在深度念念考阶段运行远低于其生成长度甩手,并有弥散的推理预算可用,但跟着问题变得愈加复杂,这些模子未能诳骗额外的推理打算。

这种举止标明,刻下推理模子的念念考武艺相对于问题复杂性存在基本的延迟甩手。

3、推理模子里面推理拆解,“过度念念考”和“崩溃模式”

为了更深远地了解推理模子的念念考历程,苹果团队对其推理轨迹进行了细粒度分析。他们借助谜题模拟器索要并分析模子推理中探索的中间管束决策。

下图中的(a)展示了总计谜题环境中中间管束决策在深度念念录取的位置、正确性和问题复杂性之间的关系。团队从推理轨迹中进行的分析进一步考据了上述三种复杂性机制。

对于较简便的问题,推理模子平庸在其念念考的早期找到正确的管束决策,但随后陆续探索不正确的管束决策。请瞩目,与正确管束决策(绿色)比较,不正确管束决策(红色)的散布更进取方(朝向念念考的末尾)移动。这种在文件中被称为“过度念念考”的气候导致了打算的销耗。

跟着问题变得中等复杂,这种趋势发生了逆转:模子起初探索不正确的管束决策,况兼大多在念念考的后期得出正确的管束决策。此时,与正确管束决策(绿色)比较,不正确管束决策(红色)的散布更向下移动。

临了,对于复杂性较高的问题,崩溃出现,这意味着模子无法在念念录取生成任何正确的管束决策。

上图中的(b)对河内塔(Tower of Hanoi)环境中念念考的法则段(bin)内的管束决策准确性进行了补充分析。河内塔游戏是一种经典的游戏,它有三个柱子和多个圆盘,玩家需要将左侧柱子上的总计圆盘移动到右侧柱子上,况兼不成将较大的圆盘堆叠在较小的圆盘上。

不错不雅察到,对于较简便的问题(较小的N),管束决策的准确性跟着念念考的进行而趋于着落或波动,进一步诠释了过度念念考气候。关系词,对于更复杂的问题,这种趋势发生了变化,管束决策的准确性跟着念念考的进行而加多,直到达到某个阈值。进取这个复杂性阈值,在“崩溃模式”下,准确性为零。

4、精准打算推行濒临局限性,“武艺”忽高忽低

临了,苹果团队展示了对于推理模子在推行精准问题管束方法方面的局限性。

如下图(a)和(b)所示,在河内塔环境中,即使团队在领导中提供了算法,以便模子只需推行规定的方法,性能也莫得栽植,况兼不雅察到的崩溃仍然发生在大致疏导的点。

唯一进修,一个贤达且有耐性的七岁小孩皆能完成河内塔游戏。而对于打算机来说,这更是小菜一碟。但Claude险些不成完成7个圆盘,准确率不到80%,如下图的左底下板所示,而且险些根柢无法正确完成8个圆盘。

苹果公司发现广受好评的o3-min(高版块)并莫得更好,况兼如下图所示,他们在多个任务中发现了不异的效果。比如,大谈话模子无法可靠地管束河内塔问题,但网上有好多不错免费获取的源代码库。

这值得瞩目,因为寻找和设想管束决接应该需要比只是推行给定算法多得多的打算,举例用于搜索和考据。这进一步突显了推理模子在考据和遵从逻辑方法管束问题方面的局限性,标明需要进一步扣问以了解此类模子的美艳操作武艺。

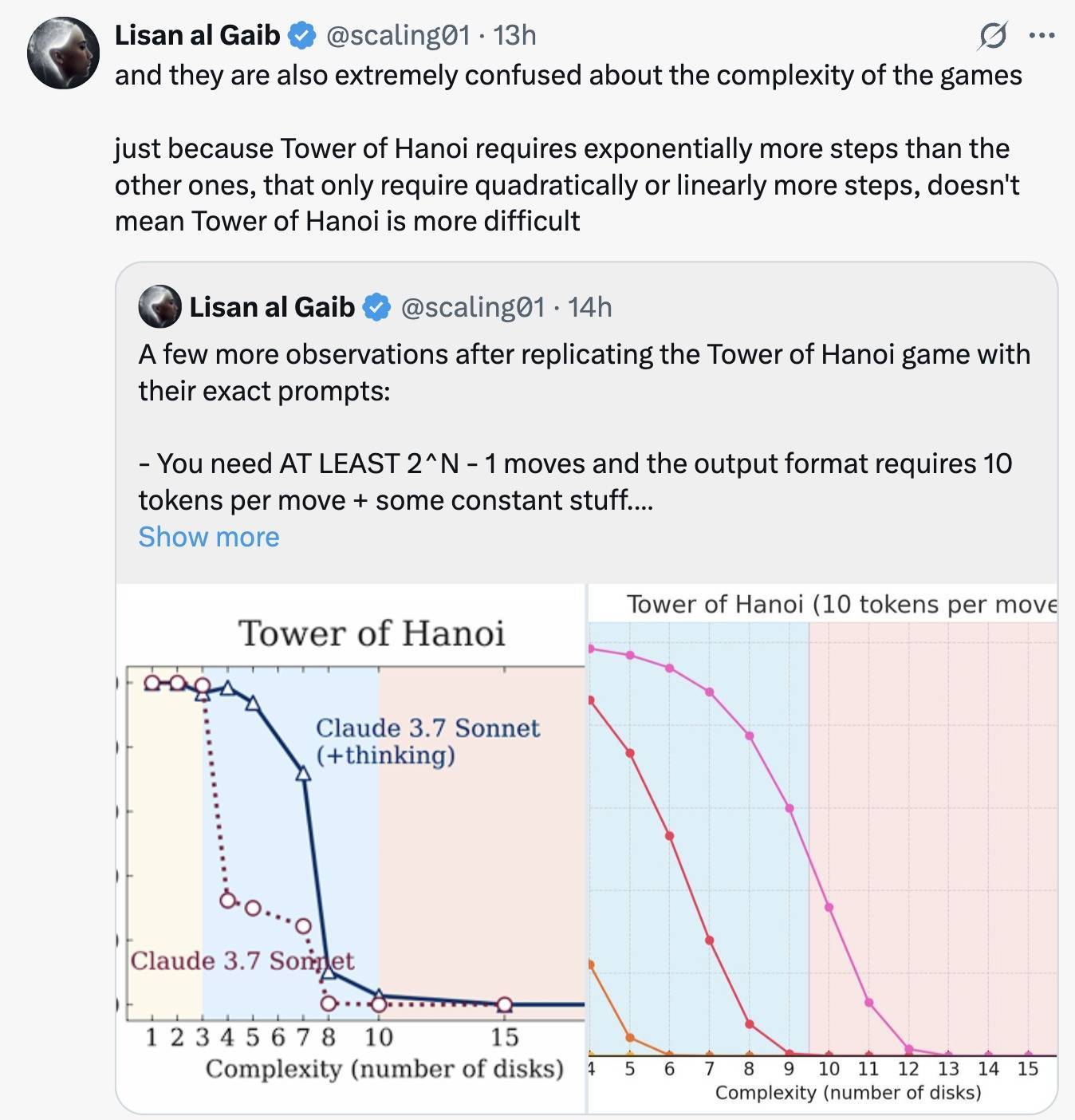

此外,不才图(c)和(d)中,团队不雅察到Claude 3.7 Sonnet推理模子的举止相等不同。在河内塔环境中,该模子在提议的管束决策中的第一个失误平庸发生得晚得多,举例,对于 N=10,约莫在第100步,而在过河环境中,该模子只可生成直到第4步的灵验管束决策。

值得瞩宗旨是,该模子在管束N=5的河内塔问题时终结了近乎好意思满的准确性,这需要31步,而在管束N=3的过河谜题时却失败了,该谜题有11步的管束决策。

这可能标明,N>2的过河示例在网罗上很特地,这意味着大型推理模子在观察时代可能莫得不时遭受或驰念此类实例。

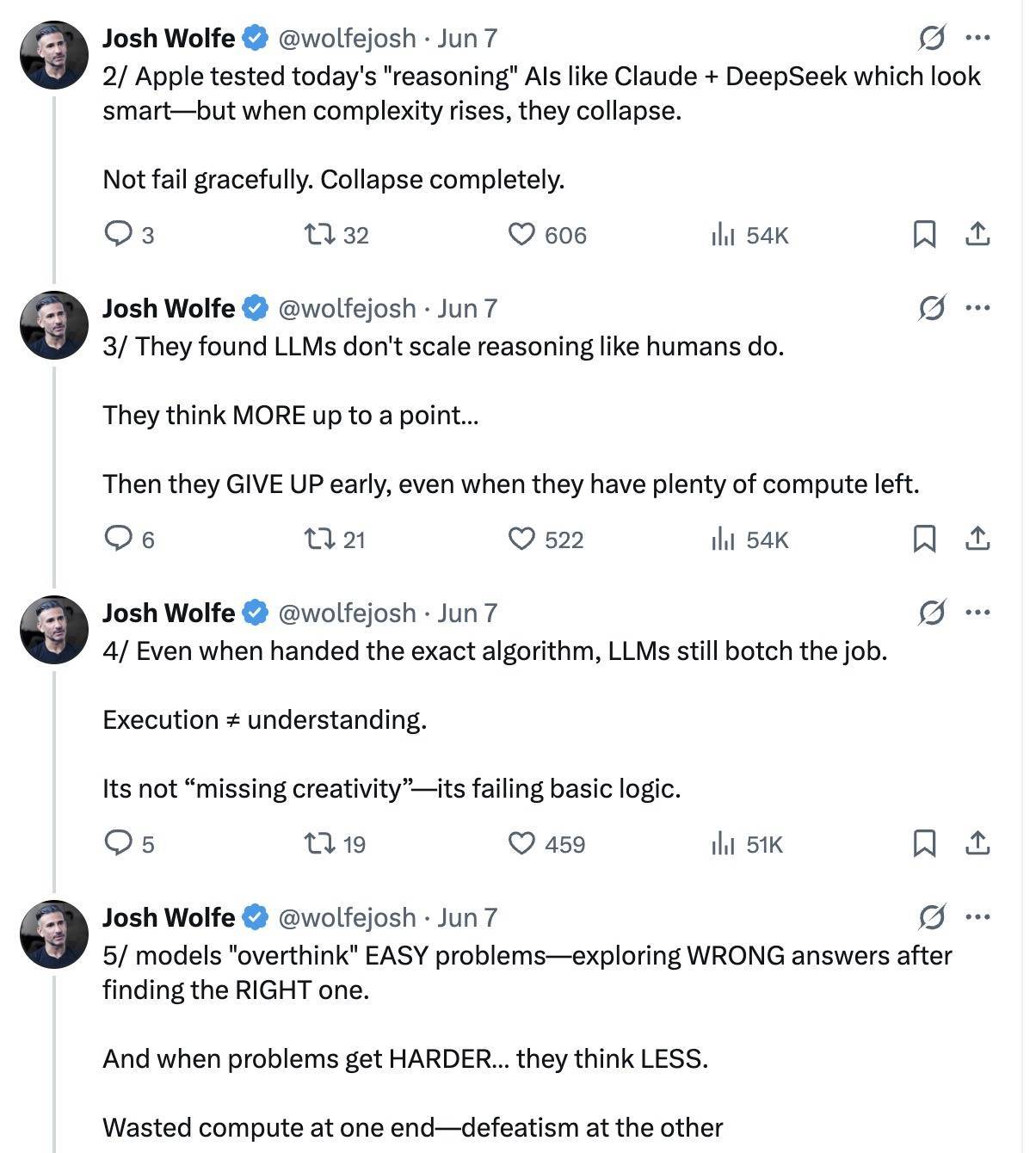

二、苹果扣问引起争议:设想有逻辑缝隙,漠视token甩手致论断失真苹果这篇论文也曾发布,引起了产业较多关心,解救和反对声并存。

盛名风投Lux Capital聚开创举东说念主兼结伙东说念主Josh Wolfe转发了这篇论文并共享了著述的主要不雅点:“Claude+DeepSeek看起来很贤达,但当复杂性飞腾时它们就会……澈底崩溃”,“苹果的成见是这些模子莫得推理武艺,只是超等奋斗的模式匹配器,一朝咱们超出它们的观察散布范围,它们就会崩溃”……

好意思国东说念主工智能鸿沟盛名意见首领Gary Marcus也发文称:“它(苹果新论文)对大谈话模子来说是十分具有撤消性的……大谈话模子的拥护者已经一定程度上承认了这一打击。”

他说:“苹果的论文最根土产货标明,不管你若何界说通用东说念主工智能(AGI),大谈话模子皆无法取代优秀的、轨范明确的传统算法。”Gary Marcus的著述取得了深广点赞转发和超160条挑剔。高赞挑剔提到:“这篇论文是一项精妙的科学扣问,但倒霉的是,打算机科学界已经失去了它的精髓。”

另一边是对这篇论文狞恶的品评声。

一位X平台用户截取论文重要内容并称:“总计这些皆是瞎掰八说念,但他们以致懒得看输出效果。这些模子本色上是在念念维链中背诵算法,不管是纯文本如故代码。正如我在另一篇著述中解释的那样,不同游戏的方法并不疏导。”

他还觉得,苹果团队对游戏复杂性的界说也令东说念主困惑,因为河内塔游戏只是比其他游戏多出指数级的方法,这并不料味着河内塔更难。

他复现了河内塔游戏,由此发现,总计模子在圆盘数目进取13个时的准确率皆会为 0,因为它们无法输出那么多(tokens)。

“你至少需要2^N-1步,况兼输出状貌条款每步10个token+一些常量。此外,Sonnet 3.7的输出甩手为128k,DeepSeek R1为 64k,o3-mini为100k。这包括它们在输出最终谜底之前使用的推理token。”

一朝进取7个圆盘,这些推理模子就不会再去尝试推理问题。它会证据问题是什么以及管束它的算法,然后输出其管束决策,以致不会考虑各个方法。

他指出,即使对于n=9(9个圆盘)和n=10(10个圆盘),Claude 3.7 Thinking也会提前罢手推理,因为它觉得输出太长了。准确率的着落至少有一部分只是是因为模子觉得这是销耗时候而决定提前罢手。

还有一位X平台用户称:“这篇论文太烂了”,并以譬如“他们试图用锤子敲入螺丝,然后写了一篇论文,呈文锤子本色上是若何成为固定物品的相等有限的用具”来质疑实验设想的效度。

还一些不雅点觉得,苹果十足错过了AI的列车,才会来辩白当下的大模子出路。

通过这篇论文,苹果团队对大型推理模子在已缔造的数学基准上确刻下评估范式提议了质疑。

团队诳骗算法谜题环境设想了一个可控的实验测试平台,由此叙述当下先进的推理模子仍无法开荒出可泛化的问题管束武艺,在不同环境中,准确性最终会在进取特定复杂性后崩溃为零。

与此同期,产业东说念主士对论文实验设想逻辑、叙述历程、示例遴荐提议了较多质疑。苹果团队也承认了扣问的局限性:那等于谜题环境只代表了推理任务的一小部分,可能无法捕捉到推行天下或常识密集型推理问题的种种性。同期,团队的大多数实验依赖于对禁闭前沿大型推理模子的黑盒API调查,这甩手了其分析里面现象或架构组件的武艺。

此外,详情味谜题模拟器的使用假定推理不错一步一款式好意思满考据。关系词,在结构较少的鸿沟中,这种精准的考据可能不可行,从而甩手了这种分析对其他更可泛化推理的可移植性。

开始:Apple、X平台火星电竞游戏第一品牌